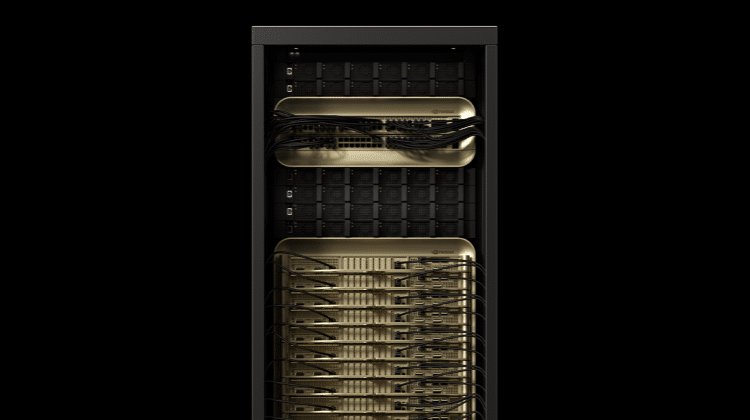

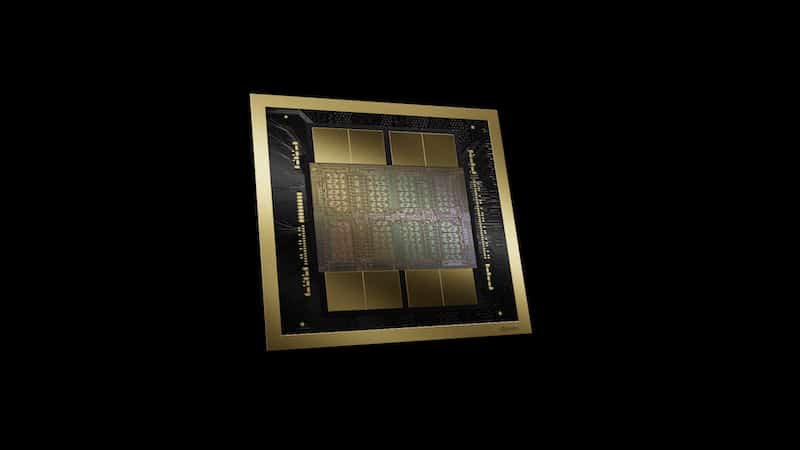

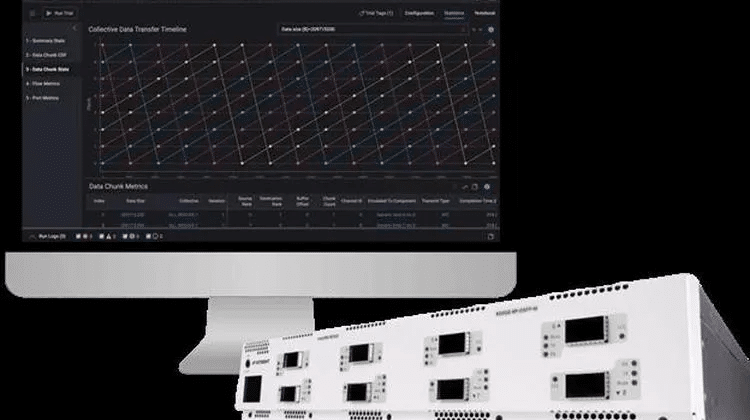

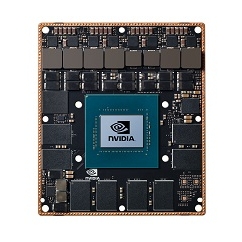

NVIDIA針對人工智慧(AI)推論的效能需求,推出新的MLPerf基準NVIDIA Orin。NVIDIA Orin是基於NVIDIA Ampere架構的低功耗SoC,有助於提升邊緣運算加速器的效能。同時MLPerf推論2.0強化資料中心與邊緣運算應的多元應用,在邊緣端離線的情況下,支援多數據流(Multi stream),可收集不同情境中的多個感測器與鏡頭的數據。

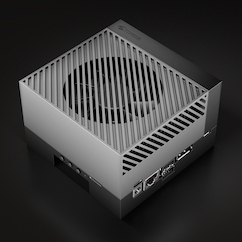

在邊緣AI,預先生產的NVIDIA Orin版本,在六項效能測試值中,有五項測試排名第一,且運算速度比上一代的Jetson AGX Xavier快五倍,能源使用效益提高兩倍。目前已經可以在Jetson AGX Orin開發套件中使用NVIDIA Orin,用於機器人與車用系統。

只要伺服器及裝置配備NVIDIA GPU,包含Jetson AGX Orin,就是市場上少數能運算全部共六個MLPerf基準的邊緣加速器。JetPack SDK則是已經在資料中心與雲端獲得認可的軟體堆疊(Stack),Jetson AGX Orin透過結合JetPack SDK,可以運算整個NVIDIA AI平台。

軟體方面,TensorRT有助於優化AI模型,Triton推論伺服器則增加部署效率。Triton支援不同的架構與GPU網路,也能整合CSP提供的服務。效能方面,Triton可以協助伺服器中的GPU提升99~100%的效能,CPU則能提升107%。